Chiunque abbia concretamente pensato di condurre o far condurre un test di neuromarketing o, più un generale, un test che implichi la raccolta di dati psicofisiologici, si sarà trovato di fronte ad una fatidica domanda: quante persone devo reclutare per il mio test perché questo sia sufficientemente rappresentativo?

Per rispondere a questa domanda è necessario scomodare qualche libro di statistica, ma state tranquilli…non ci addentreremo troppo nei luoghi oscuri di questa disciplina. Abbiamo volutamente semplificato al massimo l’argomento, quindi vi esortiamo a non utilizzare questo contenuto come Bignami ad un esame di statistica. Piuttosto – sempre che non lavoriate all’ISTAT – prendetevi la libertà di fare bella figura di fronte ai colleghi durante il break alla macchinetta del caffè.

In questo articolo ci limiteremo infatti ad introdurre alcuni concetti che vi permetteranno di comprendere cosa comporti aumentare o ridurre la numerosità del campione.

1° La distribuzione normale

Per chi ha esperienza di interviste e questionari, sapere che per un test di neuromarketing potrebbero bastare una quindicina di persone probabilmente lo spiazzerà. Vi sembrerà strano ma esiste un motivo molto semplice alla base. L’oggetto dell’indagine è diverso, così come è assai differente la tipologia di dati che vengono raccolti. I dati psicofisiologici (come ad esempio le onde cerebrali, la dimensione della pupilla, il battito cardiaco, etc…), sono dati che si distribuiscono normalmente. Distribuirsi normalmente significa che se proviamo per esempio a rappresentarli, assomiglierebbero a questo grafico (Figura 1).

Figura 1. Distribuzione normale o gaussiana

Se questa immagine rappresentasse la distribuzione della frequenza cardiaca della popolazione mondiale potremmo asserire senza problemi che sarà molto più probabile trovare persone che hanno una frequenza cardiaca a riposo attorno agli 80 battiti al minuto (colonna centrale tratteggiata), rispetto a chi ne ha 40 (una delle prime colonne a sinistra) o 120 (una delle ultime colonne a destra). Più persone ci sono in quella condizione e più quella colonna sarà “alta”.

2° L’analisi di varianza

L’analisi della varianza (ANOVA, ANalysis Of VAriance) è una tecnica di analisi dei dati che consente di verificare ipotesi relative a differenze tra le medie di due o più popolazioni (selezionate a campione). Rimanendo sempre in ambito battito cardiaco, se per esempio volessimo sapere quanto sia affidabile un determinato cardiofrequenzimetro da polso nella misurazione del battito cardiaco, sarà sufficiente confrontare i dati registrati contemporaneamente dai vari cardiofrequenzimetri e da un ECG di derivazione medicale che fungerà da misura di riferimento.

Tanto più grande sarà la differenza tra le due misurazioni rispetto a quella di rifermento tanto più inaffidabile risulterà quel dispositivo.

L’analisi della varianza è una tecnica statistica di tipo parametrico il che significa prima di tutto assumere che la variabile di interesse si distribuisca normalmente nella popolazione e che i due campioni siano estratti in maniera casuale dalla popolazione. Inoltre la numerosità campionaria è rilevante e nel confronto tra più campioni le varianze devono essere omogenee.

Certo, spiegarvi tutto quello che c’è da sapere sull’ANOVA è un tentativo perso in partenza. Non è questa la sede, ma se volete approfondire l’argomento con noi sappiate che in TSW facciamo anche formazione intorno a queste tematiche.

Consapevoli quindi che quello che abbiamo detto finora non sarà sufficiente a chiarirvi completamente le idee, vi presentiamo comunque un’analisi EEG che abbiamo condotto su uno spot televisivo della durata di 30 secondi.

L’analisi degli spot è uno dei servizi a nostro avviso più interessanti che è possibile fare con l’EEG.

Nel caso specifico abbiamo svolto un’ANOVA utilizzando il tempo (30 secondi) come fattore.

Appunto per i più tecnici: per ragioni legate alla leggibilità del grafico non abbiamo rappresentato (secondo per secondo) gli errori standard della media o gli intervalli di confidenza.

Lo scopo di questo articolo è infatti quello di farvi capire quale sia la differenza in termini di risultati tra un test condotto con 15 e un test con 40 partecipanti. La letteratura ci suggerisce che per studi simili sono stati impiegati al massimo 40 partecipanti: quindi prendiamo questa numerosità come limite di riferimento (Ohme et al., 2009; 2010).

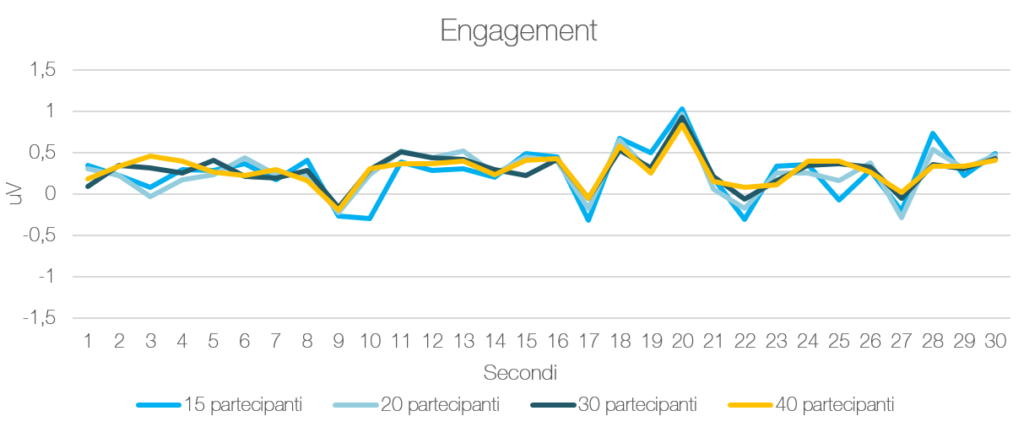

In particolare metteremo sotto lente d’ingrandimento le variazioni dei livelli di engagement, derivanti dall’analisi delle onde cerebrali (McMahan et al., 2015) e le considerazioni che ne conseguono aumentando gradualmente la numerosità del campione (da 15 a 40 partecipanti).

Qui sotto è rappresentato graficamente l’andamento medio del livello di engagement derivato dall’analisi EEG fatta sullo stesso spot televisivo per 15, 20, 30 e 40 partecipanti.

Figura 2. Andamento medio del livello di Engagement per gruppi di analisi composti rispettivamente da 15, 20, 30 e 40 partecipanti

3° La correlazione

La correlazione esprime la relazione esistente tra due variabili. Tale valore varia tra –1.00 (correlazione negativa) e +1.00 (correlazione positiva). Una correlazione uguale a 0 indica che tra le due variabili NON vi è alcuna relazione. Semplificando il più possibile, una correlazione si può ritenere positiva e forte se raggiunge valori superiori a 0.70.

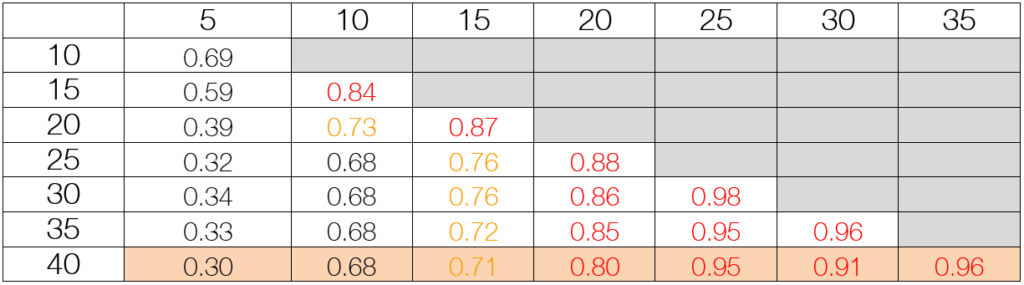

La tabella sottostante spiega esattamente cosa succede da un punto di vista delle correlazioni con campioni che vanno da 5 a 40 persone.

Tabella 1.

Matrice di correlazione

Guardiamo come si comportano i gruppi rispetto all’analisi fatta con 40 partecipanti (Tabella 1). Come potete notare l’analisi con 5 o 10 partecipanti non è sufficientemente correlata con l’analisi svolta con 40. Ma già con 15 partecipanti sappiamo che stiamo percorrendo la strada corretta. Con 20 partecipanti raggiungiamo invece valori eccellenti che ci permettono di dire che aumentare il numero di utenti (fino a 40) non fornisca vantaggi reali tali da giustificare l’investimento.

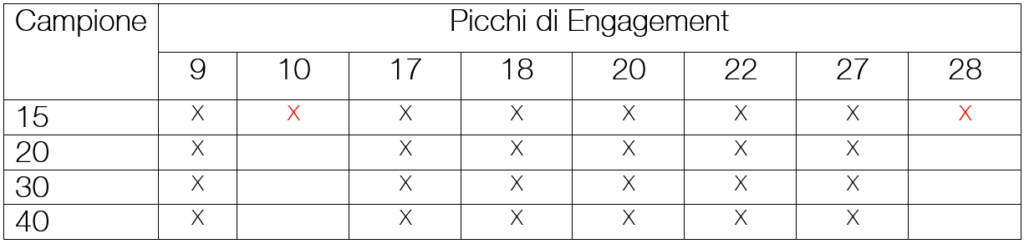

Come si evince dalla Figura 2, gli andamenti e le tendenze sono piuttosto simili tra loro. Tuttavia la percezione grafica non sempre va di pari passo con la statistica. Quindi siamo andati a valutare secondo per secondo quali momenti si differenziassero dal livello medio di engagement dell’intera esperienza, ovvero quelli che noi definiamo picchi.

La tabella sottostante semplifica il lavoro minuzioso di analisi e permette facilmente un confronto dei risultati che si potrebbero ottenere con le diverse numerosità.

Tabella 2. Picchi di engagement per campioni diversi. In colonna i secondi in cui sono stati osservati picchi di engagement, in riga il numero di partecipanti.

Come potete notare, per questo spot, l’analisi svolta con un campione di 20 persone permette di individuare le stesse criticità che derivano dall’analisi fatta con il doppio degli utenti (40).

È interessante constatare come con 15 partecipanti si evidenzino tutte le criticità, sovrastimando le differenze per i picchi rilevati al secondo 10 e al secondo 28 (non più osservabili dalle analisi fatte con 20 partecipanti). Se da un lato è vero che già con 15 abbiamo risultati correlati in maniera forte (i.e. 0.71) con un campione di 40, dall’altro ciò non significa che non vi siano differenze tra le due osservazioni.

Concludendo, speriamo di avervi fatto capire (senza troppi mal di testa) che la scelta della numerosità non dipende da considerazioni personali ma da considerazioni statistiche strettamente legate agli scopi e all’oggetto dell’indagine. In ultima battuta ci sembra importante sottolineare che tali considerazioni possano essere estese a tutti i gruppi che si desiderano analizzare. Ad esempio se si desiderasse sapere se vi siano differenze tra maschi e femmine, avremo bisogno di almeno 15/20 persone di sesso maschile e altrettante di sesso femminile. Ciascun ulteriore confronto rispetterà le medesime regole. Arrivati a questo punto dovremmo aver compreso che la scelta della numerosità di un campione dipende soprattutto dagli obiettivi che ci poniamo: più cose vogliamo sapere, più grande dovrà essere il campione da reclutare. Ma possiamo finalmente scordarci dei numeri necessari per le interviste!

Bibliografia

McMahan, T., Parberry, I., & Parsons, T. D. (2015, June). Evaluating Electroencephalography Engagement Indices During Video Game Play. In FDG.

Ohme, R., Reykowska, D., Wiener, D., & Choromanska, A. (2009). Analysis of neurophysiological reactions to advertising stimuli by means of EEG and galvanic skin response measures. Journal of Neuroscience, Psychology, and Economics, 2(1), 21.

Ohme, R., Reykowska, D., Wiener, D., & Choromanska, A. (2010). Application of frontal EEG asymmetry to advertising research. Journal of Economic Psychology, 31(5), 785-793.